[논문 리뷰] [CV] Delving Deep into Rectifiers:Surpassing Human-Level Performance on ImageNet Classification

0. Reference

https://arxiv.org/abs/1502.01852

Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification

Rectified activation units (rectifiers) are essential for state-of-the-art neural networks. In this work, we study rectifier neural networks for image classification from two aspects. First, we propose a Parametric Rectified Linear Unit (PReLU) that genera

arxiv.org

1. Introduction

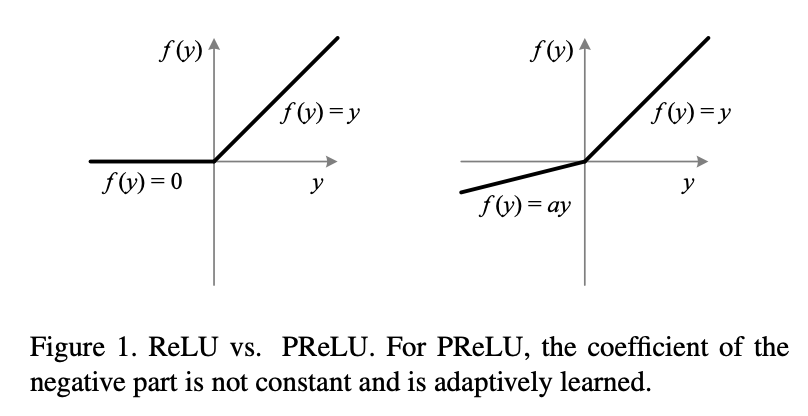

- 해당 논문에선 ReLU의 generalization버전인 PReLU(Parametric Rectified Lienar Unit, PReLU)에 대해 설명한다.

- 해당 Activation function은 rectifiers의 parameter를 자동으로 학습하며,

- 추가적인 계산 비용없이 성능을 향상시킨다고 한다.

2. Approach

2.1. PReLU

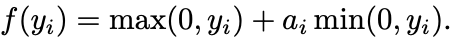

- PReLU는 다음과 같이 정의된다.

- 여기서 a_i는 학습가능한 parameter로 Back-propagation을 통해 학습된다.

- 이를 간략하게 다음과 같이 표기가능하다.

- 여기서 a_i가 0.01로 고정되면, Leaky ReLU와 같아진다.

- 본 논문에선, Leaky ReLU가 그냥 ReLU를 사용할 때보다 성능이 더 떨어졌다고 한다.

- 하지만, PReLU는 a_i가 학습가능한 parameter이기 때문에, 더 optimal한 activation function이 된다고 주장한다.

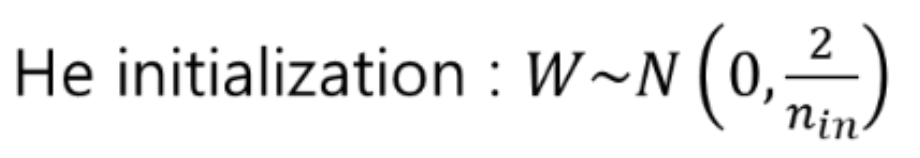

2.2. He Intialization

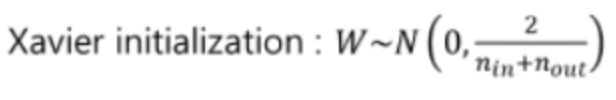

- layer들의 weight의 intialization은 학습에 큰 영향을 끼치게 된다.

- 처음에 Xavier intialization을 도입하였더니, ReLU,PReLU에선 유의미한 결과를 도출하지 못했다고 한다.

- 그래서 He initialization을 도입하였더니, 학습이 잘되었다고 주장한다.

cf) Xavier Initialization과 He Initialization에 대한 리뷰는 다음 포스팅을 참고바랍니다.

- Xavier Initialization

https://ceulkun04.tistory.com/227

[논문 리뷰] [DL] Understanding the difficulty of training deep feedforward neural networks

0. Referencehttps://proceedings.mlr.press/v9/glorot10a.html Understanding the difficulty of training deep feedforward neural networksWhereas before 2006 it appears that deep multi-layer neural networks were not successfully trained, since then several alg

ceulkun04.tistory.com

- He Initalization같은 경우,

- ReLU에 의해 weight가 절반이 죽어버리기 때문에, 이를 분산을 2배를 하여 이를 커버한다.

3. Model Architecture

- 해당부분은 중요하진 않은거 같아 논문참고 부탁드립니다.