0. Reference

https://arxiv.org/abs/1603.09382

Deep Networks with Stochastic Depth

Very deep convolutional networks with hundreds of layers have led to significant reductions in error on competitive benchmarks. Although the unmatched expressiveness of the many layers can be highly desirable at test time, training very deep networks comes

arxiv.org

1. Introduction

- 본 논문은 ResNet의 성능향상에 focus를 두고 있다.

- Network의 depth는 모델의 representation을 결정짓는 핵심 요소이다.

- 하지만, 매우 깊은 모델은 다음과 같은 문제점을 동반하게 된다.

i) Gradient Vanish

ii) Forward때, feature reuse(불필요한 feature)

iii) 너무 긴 학습시간

- 우선 Gradient Vanish를 해결하기위해, 깊어질때마다 Identity mapping을 층 사이에 넣어 손실없이 전달할 수 있도록 돕는다.

- 하지만, 그만큼 시간이 너무 오래걸리고, 불필요한 feature를 reuse하는 단점을 가지게 된다.

- 본 논문에선 Stochastic Depth라는 새로운 학습 알고리즘을 제안한다.

- 해당 알고리즘의 아이디어는 다음과 같다.

"학습할 때는 얕은 Network가 좋고, test할 때는 깊은 Network가 좋다."

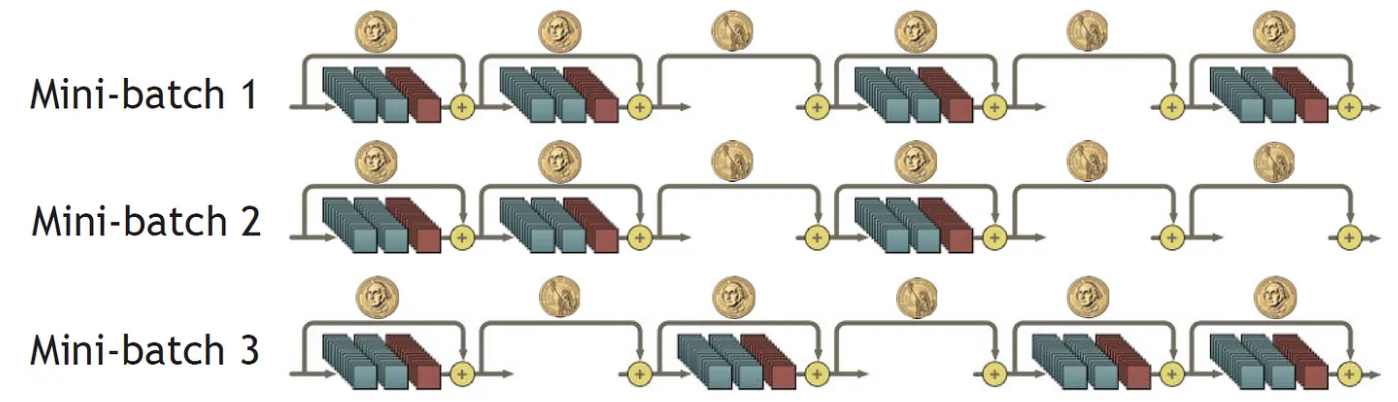

- 이를 구현하기위해, 깊은 Residual Block을 연결하고(수백~수천 층)

- 학습 중에는 각 sample이나 mini-batch마다 층을 무작위로 생략시킨다.

- 이렇게 된다면,

- 평균적으로 학습할 때, 얕은 네트워크가 들어가게 되고,

- test시, 전체깊이를 이용하면 되지 않을까?

- 라는 아이디어라고 생각하면 된다.

- 이러한 Stochastic Depth의 장점은 다음과 같다.

i) 학습 시간 단축

ii) test ACC 향상

- Backpropagation 경로가 짧아지면서 초반 층까지 더 강한 gradient를 전달하게 된다.

- 서로 다른 깊이의 Network들이 암묵적으로 Ensemble한 것과 유사한 효과를 보인다.

- 마치 Dropout과 유사한 형태라고 생각하면 좋을것 같다.

iii) Regularization 효과가 있다.

2. Dropout에 대해 더 자세히!

- Dropout은 유닛들이 서로 co-adaptation하는 문제를 줄이고, Regularizaiton하는 효과가 존재한다.

- 이러한 Dropout은 수많은 작은 Network들을 ensemble하는 방식으로 학습시키는 것과 유사하다고 말할 수 있다.

- 참고로, 이러한 Dropout은 Batch Normalization과 함께 사용하면 효과가 거의 없거나 성능을 저하시킬수 있다고한다.

- 특히, ResNet처럼 이미 안정화된 Network에선 Dropout이 큰 효과를 보이지 않을 수 있다고 한다

- 이러한 Dropout을 Layer 각각을 유닛이라 생각하고 적용(Stochastic Depth)하였더니,

- Batch Normaliation을 함꼐 사용해도 성능 향상이 보였음을 확인하였다고 한다.

3. Deep Networks with Stochastic Depth

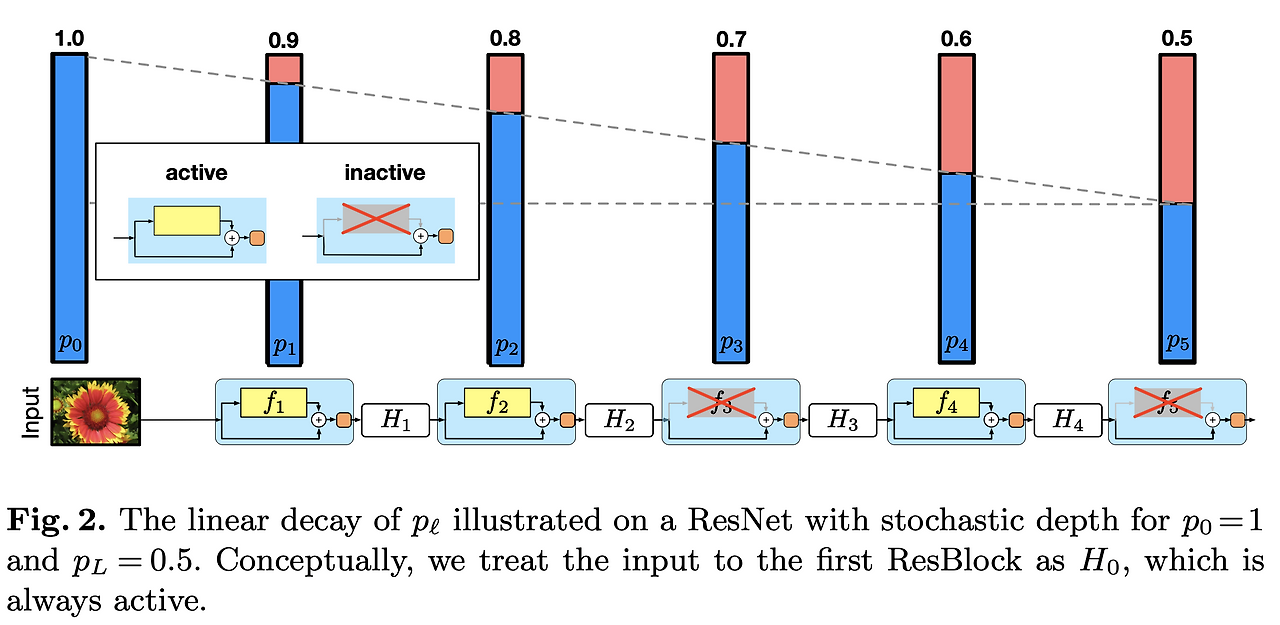

- 여기서 b는 Drop_ratio같은 아이라고 생각하면 좋다.

- 여기선 survival probability라고 지칭한다.

cf) timm library에서 droppath로 구현되어있다고한다.

'Paper Review(논문 리뷰) > Computer Vision' 카테고리의 다른 글

| [논문 리뷰] [CV] Densely Connected Convolutional Networks (1) | 2025.03.27 |

|---|---|

| [논문 리뷰] [CV] SQUEEZENET: ALEXNET-LEVEL ACCURACY WITH50X FEWER PARAMETERS AND <0.5MB MODEL SIZE (0) | 2025.03.26 |

| [논문 리뷰] [CV] Wide Residual Networks (1) | 2025.03.26 |

| [논문 리뷰] [CV] Highway Networks (0) | 2025.03.23 |

| [논문 리뷰] [CV] Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning (0) | 2025.03.23 |